Hola Elementales,

Nuestro amigo Martin me preguntaba entre otras cosas muy interesantes si la velocidad de la luz c "es siquiera constante en el vacío como prueban experimentos recientes". Podeis verlo en nuestra entrada anterior "Relatividad Especial y la velocidad de la luz".

Vamos a empezar por decir que el estado actual de nuestro conocimiento sobre las fuerzas de la naturaleza no es satisfactorio en muchos sentidos, pero especialmente en lo relativo al elevado número de constantes, aparentemente fundamentales, y que hay que ajustar empíricamente, no pueden deducirse a partir de principios sencillos. Ya se está trabajando en ello.

Otro de los aspectos no deseables es el hecho de que dependan de la unidad de medida seleccionada ya que muchas de ellas no son adimensionales. Así, algunas dependen de si decidimos medir en el sistema metrico decimal (metros, segundos, etc..) o en otro sistema (pulgadas, libras, etc...) y precisamente buscamos lo contrario: que sean Universales...

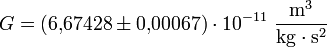

La Constante de Gravitación Universal: G

La primera constante fundamental es G, la que ponemos delante de la fórmula de la gravedad de Newton.

Es una simple constante de proporcionalidad pero tambien ajusta magnitudes: se expresa en N*m2/

Kg2.

Es tal vez la constante peor medida (sólo se está seguro de las tres primeras cifras...), y como vemos la fuerza de la gravedad es muy débil (si no fuera porque siempre es atractiva ni la sentiríamos).

La Constante Electrica: K

No confundir con la constante K de Bolzman para termodinamica y gases..

La ley de Coulom es practicamente igual a la de la gravitación de Newton, si sustituimos las masas por las cargas, es inversa al cuadrado de la distancia y tiene una constante de proporcionalidad llamada K

La constante es la de de Coulomb y su valor para unidades del SI es K = 9 * 109 * N * m2 / C2

La constante K no es realmente fundamental, ya que es K=

y

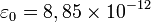

es la Permitividad Relativa del material (siempre es menor o igual que 1) y

F/m es la Permitividad del Medio en el Vacío

Así pues, la constante importante es la Permitividad del Vacío.

Hay un paralelismo casi total con el campo magnético, donde definimos la "Permeabilidad Magnética de un material" como la Permitividad Relativa por la Permitividad del Vacío, μ = μrμ0, donde la importante es de nuevo la del vacío.

Pues bien, para enorme sorpresa de

James Clerk Maxwell, cuando terminó sus famosísimas ecuaciones que unificaban definitivamente la electricidad y el electromagnetismo, descubrió que dichas ecuaciones cumplían una ecuación de onda y al despejar la velocidad de dicha onda obtuvo el siguiente y sorprendente resultado, la velocidad de esas misteriosas y (creía él) aún no observadas ondas electromagnéticas era ni más ni menos que la inversa de la raiz cuadrada del producto de la permitividad electrica, por la permeabilidad magnetica (ambas en ese medio). Así calculó la velocidad en el vacío y se sorprendió al descubrir que coincidía con la velocidad de la luz, que más o menos se conocía bien por aquella época. ¡Luego sus ecuaciones demostraban que la luz no era sino una onda electromagnética! Después hemos descubierto que hay más tipos de ondas electromagnéticas y que la luz no sólo es una onda si no que además está cuantificada en paquetes, llamados "fotones". También la gravedad se cree que se propaga a la velocidad de la luz (tanto en la Relatividad General como en los modelos que incluyen la mecanica cuantica: gravitones, etc...)

La velocidad de la luz c

La velocidad de la luz c

c= 299.792.458 m/s y se suele aproximar por 3·10^8m/s

Que la velocidad de la luz es una constante se comprobó hasta la saciedad en diversos experimentos, como el famoso

experimento Michelson-Morley que determinó mediante un interferómetro que la velocidad de la luz no dependía de la velocidad del objeto que la emitía, esto descartó de golpe la suposición de que hubiera un "eter" o sustancia necesaria por la que se propagara la luz. En su lugar aparecieron las famosas transformaciones de Lorenz, la

contracción de Lorentz explicaba el resultado del experimento. La rapidez constante de la luz es uno de los postulados fundamentales (junto con el principio de causalidad y la equivalencia de los marcos de inercia) de la Teoría de la Relatividad Especial.

Así pues si el vacío es homogeneo y anisótropo podemos afirmar que la velocidad de la luz es igual en todo el Universo...¿o no? Al fin y al cabo se trata de medidas empíricas realizadas ahora (en nuestro momento del tiempo y en nuestro pequeño rincón del Universo...)

Hay teorías que sostienen que tal vez el Universo no está acelerando su expansión, que no hace falta inventar una nueva fuerza (como la supuesta energía oscura), puede que simplemente al final de todo, la velocidad de la luz c no sea constante a lo largo del tiempo, y haya podido variar según alguna ley que aún no conocemos...pero como vemos es imposible mover c sin que varíe la propia fuerza electro-magnética y como sabemos además también variaría la fuerza nuclear débil y creemos que el resto de fuerzas: la nuclear fuerte practicamente seguro y sospechamos que tambien la gravedad... Habría que comprobar si todo esto es posible (¿es mesurable el efecto que tendría su modificación en el pasado?) y además dicha modificación debería ser coherente y compatible con todas las características de las fuerzas ya conocidas...

La constante de Planck: h

También conocida como ħ=h/2π la constante reducida. Es el cuanto elemental de acción

;

(es muy, muy pequeña...)

Representa la relación o constante de proporcionalidad entre la frecuencia y la energía de un fotón o cuanto de luz. Cuanto más frecuencia mayor energía posee un fotón. Así algunos rayos gamma que se reciben desde el espacio tienen una energía increible (los denominan coloquialment OMD Oh My God...).

Max Planck la descubrió en 1901 como única forma de explicar la radiación del cuerpo negro, él mismo publicó que sin duda sería falsa pero era la única que lo explicaba: se equivocó en este comentario, el Universo es cuántico. Tiró por tierra toda la imagen del mundo contínuo que se tenía por verdadedro anteriormente.

Lo cierto es que su constante aparece por todos lados del mundo subatómico o cuántico: en el momento angular de una partícula, en su energia, en el principio de incertidumbre de Heisenberg: la incertidumbre de una medida de la posición y de una medida de la cantidad de movimiento a lo largo del mismo eje sigue la relación:

También se ha asociado con la distancia mínima con sentido o distancia de Planck . Distancia a la que creemos que los efectos cuaticos de la gravedad son los que dominan.. y la hacen la fuerza más fuerte. A esas distancias también creemos que todas las fuerzas se unifican en una única (al menos las que ya conocemos...)..

Tiempo de Planck Tiempo (T) 5.39121 × 10-44 s

Longitud de Planck Longitud (L) 1.61624 × 10-35 m

Masa de Planck Masa (M) 2.17645 × 10-8 kg

Carga de Planck Carga eléctrica (Q) 1.8755459 × 10-18 C

Temperatura de Planck Temperatura (ML2T-2/k) 1.41679 × 1032 K

La constante de estructura fina α

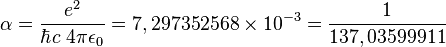

O constante de estructura fina de Sommerfeld,

Arnold Sommerfeld, α, yo diría que es realmente una constante física fundamental ya que es una

cantidad sin dimensiones, por lo que su valor no depende del sistema de medidas elegido. Caracteriza la fuerza de la interacción electromagnética.

Donde e es la carga elemental, h con barra es la constante reducida de Planck, c es la velocidad de la luz en el vacío, y ε0 es la permitividad del vacío.

O sea que su valor es aproximadamente 1/137.

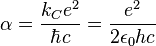

También se puede expresar como

Donde Kc es la constante de Coulomb.

En la teoría de electrodinámica cuántica, la constante de estructura fina juega el rol de una constante de acoplamiento, representando la fuerza de la interacción entre electrones y fotones. Su valor no puede predecirse por la teoría, y debe insertarse uno basado en resultados experimentales. De hecho, es uno de los veinte "parámetros externos" en el Modelo estándar de física de partículas.

En la Electrodinámica Cuántica este parámetro se puede medir directamente a partir del efecto

Efecto Hall Cuantico ¡y se ha medido con una precisión de más de 23 decimales¡ Debe de ser la constante mejor medida de todas.

En la teoría electrodébil, que unifica la interacción débil con el electromagnetismo, la constante de estructura fina aparece en otras dos constantes de acoplamiento asociadas con los campos gauge de la teoría electrodébil. En esta teoría, la interacción electromagnética se trata como una mezcla de interacciones asociadas con los campos electrodébiles.

En 2010, el científico John Webb publicó un estudio en el que revelaba datos que afirmaban que la constante no era igual en todo el universo y que se observaban cambios graduales en torno a un eje concreto de éste.

A estas constantes hay que añadir las cargas y masas del electrón, protón, etc... sólo en la Teoría Estandard hay 17 constantes (además de las mencionadas, cargas, masas, ángulos de acoplamiento, etc...).

Interacción Grupo gauge Bosón Símbolo Fuerza relativa

Electromagnética U(1) fotón α em = 1/137

Débil SU(2) W±, Z0 αweak = 1,02 · 10-5

Fuerte SU(3) gluones (8 tipos) αs(MZ) = 0,121

Como vemos, en primer lugar hay demasiadas constantes fundamentales. En segundo lugar no podemos predecir sus valores... hay que ajustarlos tras experimentar y en tercer lugar dependen casi todas del sistema de medidas (de quien ya nos ocuparemos en otra entrada, porque también tienen lo suyo que mejorar,..).

¿Que opinais vosotros? ¿son todas ellas fundamentales o no? ¿se pueden mejorar? Para mí son muy. muy mejorables...

¡Un saludo Elementales!

Francisco Jose Menchen

y

y  es la Permitividad Relativa del material (siempre es menor o igual que 1) y

es la Permitividad Relativa del material (siempre es menor o igual que 1) y  F/m es la Permitividad del Medio en el Vacío

F/m es la Permitividad del Medio en el Vacío

;

;